Porque embora os bots tenham mudado, o jogo não mudou. O conteúdo do seu site precisa ser rastreável.

Entre maio de 2024 e maio de 2025, o tráfego do rastreador de IA aumentou 96%, com a participação do GPTBot saltando de 5% para 30%. Mas esse crescimento não está substituindo o tráfego de busca tradicional.

Isso significa que os sites corporativos precisam satisfazer ambos rastreadores tradicionais e Sistemas de IA, mantendo o mesmo orçamento de rastreamento que tinham antes.

O dilema: volume de rastreamento versus impacto na receita

Muitas empresas erram na rastreabilidade porque se concentram no que podemos medir facilmente (total de páginas rastreadas) em vez do que realmente gera receita (quais páginas são rastreadas).

Quando a Cloudflare analisou o comportamento do rastreador de IA, descobriu uma ineficiência preocupante. Por exemplo, para cada visitante que Claude da Anthropic faz referência a sites, ClaudeBot rastreia dezenas de milhares de páginas. Essa proporção desequilibrada entre rastreamento e referência revela uma assimetria fundamental da pesquisa moderna: consumo massivo, retorno mínimo de tráfego.

É por isso que é fundamental que os orçamentos de rastreamento sejam direcionados de maneira eficaz para suas páginas mais valiosas. Em muitos casos, o problema não é ter muitas páginas. É sobre as páginas erradas consumindo seu orçamento de rastreamento.

A estrutura PAVE: Priorizando receitas

A estrutura PAVE ajuda a gerenciar a rastreabilidade em ambos os canais de pesquisa. Ele oferece quatro dimensões que determinam se uma página merece orçamento de rastreamento:

- P – Potencial: Esta página tem classificação realista ou potencial de referência? Nem todas as páginas devem ser rastreadas. Se uma página não for otimizada para conversão, fornecer conteúdo limitado ou tiver potencial mínimo de classificação, você estará desperdiçando um orçamento de rastreamento que poderia ir para páginas geradoras de valor.

- A – Autoridade: os marcadores são familiares para o Google, mas conforme mostrado no Índice de Visibilidade de IA da Semrush Enterprise, se o seu conteúdo não tiver sinais de autoridade suficientes – como EEAT claro e credibilidade do domínio – os bots de IA também irão ignorá-lo.

- V – Valor: quanta informação exclusiva e sintetizável existe por solicitação de rastreamento? As páginas que exigem renderização de JavaScript demoram 9 vezes mais para serem rastreadas do que o HTML estático. E lembre-se: o JavaScript também é ignorado pelos rastreadores de IA.

- E – Evolução: Com que frequência esta página muda de maneira significativa? A demanda de rastreamento aumenta para páginas que são atualizadas frequentemente com conteúdo valioso. As páginas estáticas perdem a prioridade automaticamente.

A renderização do lado do servidor é um multiplicador de receita

Se você depende da renderização do lado do cliente (CSR), em que o conteúdo é montado no navegador após a execução do JavaScript, você está prejudicando seu orçamento de rastreamento.

A renderização do lado do servidor (SSR) inverte totalmente a equação.

Com o SSR, seu servidor web pré-cria o HTML completo antes de enviá-lo aos navegadores ou bots. Nenhuma execução de JavaScript é necessária para acessar o conteúdo principal. O bot é necessário na primeira solicitação. Nomes de produtos, preços e descrições são imediatamente visíveis e indexáveis.

Mas é aqui que o SSR se torna um verdadeiro multiplicador de receita: essa velocidade adicional não apenas ajuda os bots, mas também melhora drasticamente as taxas de conversão.

- Aumento de 8,4% nas conversões de varejo

- Aumento de 10,1% nas conversões de viagens

- Aumento de 9,2% no valor médio dos pedidos para varejo

O SSR faz com que as páginas carreguem mais rápido para usuários e bots porque o servidor faz o trabalho pesado uma vez e depois fornece o resultado pré-renderizado para todos. Nenhum processamento redundante do lado do cliente. Sem atrasos na execução do JavaScript. Apenas páginas rápidas, rastreáveis e conversíveis.

Para sites empresariais com milhões de páginas, o SSR pode ser um fator chave para saber se os bots e os usuários realmente veem – e convertem – seu conteúdo de maior valor.

A lacuna de dados desconectada

Muitas empresas estão voando às cegas devido a dados desconectados.

- Os logs de rastreamento ficam em um sistema.

- Seu rastreamento de classificação de SEO reside em outro.

- Seu monitoramento de pesquisa de IA em um terceiro.

Isso torna quase impossível responder definitivamente à pergunta: “Quais problemas de rastreamento estão nos custando receita neste momento?”

Esta fragmentação cria um custo crescente de tomada de decisões sem informações completas. Todos os dias você opera com dados isolados, você corre o risco de otimizar as prioridades erradas.

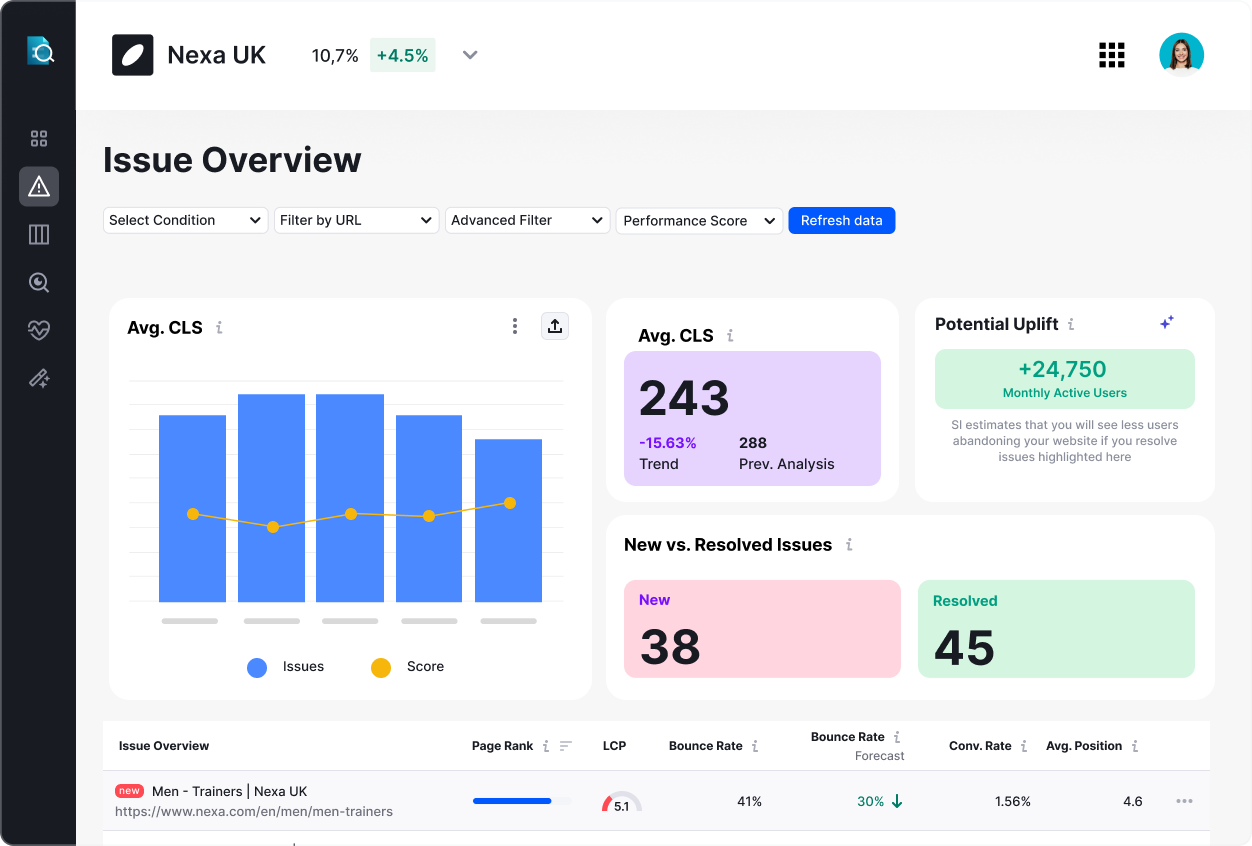

As empresas que resolvem a rastreabilidade e gerenciam a integridade de seus sites em grande escala não coletam apenas mais dados. Eles unificam a inteligência de rastreamento com dados de desempenho de pesquisa para criar uma imagem completa.

Quando as equipes podem segmentar os dados de rastreamento por unidades de negócios, comparar o desempenho pré e pós-implantação lado a lado e correlacionar a integridade do rastreamento com a visibilidade real da pesquisa, você transforma o orçamento de rastreamento de um mistério técnico em uma alavanca estratégica.

1. Conduza uma auditoria de rastreamento usando a estrutura PAVE

É aqui que o gerenciamento escalonável da integridade do site se torna crítico. As equipes globais precisam segmentar os dados de rastreamento por regiões, linhas de produtos ou idiomas para ver exatamente quais partes do seu site estão consumindo orçamento em vez de gerar conversões. Recursos de segmentação de precisão que o Site Intelligence da Semrush Enterprise permite.

Depois de ter uma visão geral, aplique a estrutura PAVE: se uma página tiver pontuação baixa em todas as quatro dimensões, considere bloqueá-la contra rastreamentos ou consolidá-la com outro conteúdo.

A otimização focada por meio da melhoria de links internos, correção de problemas de profundidade de página e atualização de mapas de sites para incluir apenas URLs indexáveis também pode gerar enormes dividendos.

2. Implementar monitoramento contínuo, não auditorias periódicas

A maioria das empresas realiza auditorias trimestrais ou anuais, tirando uma visão geral do tempo e encerrando o dia.

Mas o orçamento de rastreamento e os problemas mais amplos de integridade do site não esperam pelo seu cronograma de auditoria. Uma implantação na terça-feira pode deixar páginas importantes invisíveis na quarta-feira e você não descobrirá isso até a próxima revisão. Após semanas de perda de receita.

A solução é implementar um monitoramento que detecte os problemas antes que eles se agravem. Quando você pode alinhar auditorias com implantações, rastrear o histórico de seu site e comparar versões ou ambientes lado a lado, você passa de simulações de incêndio reativas para um sistema proativo de proteção de receita.

3. Construa sistematicamente sua autoridade de IA

A pesquisa de IA opera em etapas. Quando os usuários pesquisam tópicos gerais (“melhores botas impermeáveis para caminhada”), a IA sintetiza sites de avaliação e conteúdo de comparação. Mas quando os usuários investigam marcas ou produtos específicos (“O Salomon X Ultra é à prova d’água e quanto custa?”), a IA muda completamente sua abordagem de pesquisa.

Seu site oficial se torna a fonte primária. Este é o jogo da autoridade e a maioria das empresas está a perdê-lo ao negligenciar a sua arquitectura de informação fundamental.

Aqui está uma lista de verificação rápida:

- Certifique-se de que as descrições de seus produtos sejam factuais, abrangentes e ilimitadas (sem conteúdo com muito JavaScript)

- Indique claramente informações vitais, como preços, em HTML estático

- Use marcação de dados estruturados para especificações técnicas

- Adicione comparações de recursos ao seu domínio, não confie em sites de terceiros

Visibilidade é rentabilidade

Seu problema de rastreamento de orçamento é, na verdade, um problema de reconhecimento de receita disfarçado de problema técnico.

Cada dia em que páginas de alto valor ficam invisíveis é um dia de perda de posicionamento competitivo, conversões perdidas e perda crescente de receita.

Com o aumento do tráfego do rastreador de pesquisa e o ChatGPT agora reportando mais de 700 milhões de usuários diários, os riscos nunca foram tão altos.

Os vencedores não serão aqueles com mais páginas ou conteúdo mais sofisticado, mas aqueles que otimizarem a saúde do site para que os bots cheguem primeiro às páginas de maior valor.Para empresas que gerenciam milhões de páginas em diversas regiões, considere como a inteligência de rastreamento unificada — combinando dados de rastreamento profundo com métricas de desempenho de pesquisa — pode transformar o gerenciamento da integridade do seu site de uma dor de cabeça técnica em um sistema de proteção de receita. Saiba mais sobre Inteligência de site da Semrush Enterprise.

As opiniões expressas neste artigo são de responsabilidade do patrocinador. A MarTech não confirma nem contesta nenhuma das conclusões apresentadas acima.